El texto en las imágenes se puede traducir

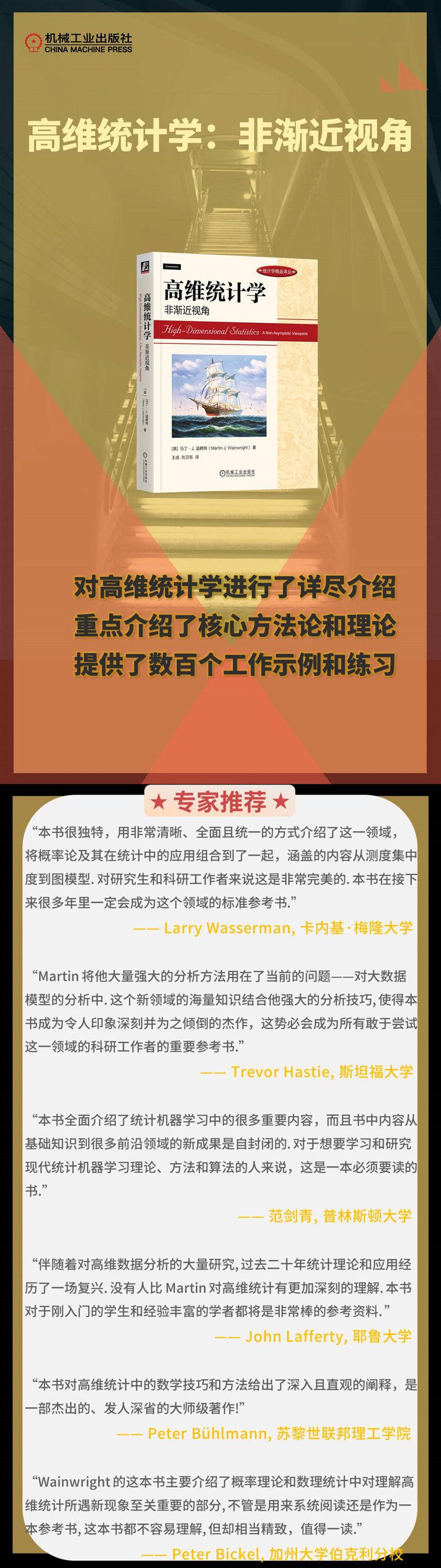

Perspectiva no asintótica de las estadísticas de alta dimensión (A NOSOTROS) Martín J.. Prensa de la industria de maquinaria estadística Wainwright

Precio por pieza incluyendo entrega a México

Cantidad

Producto seleccionado

Especificaciones del producto

Marca

42960263

Editorial

Machinery Industry Press

Autor

(american) Martin J. Wendite

Fecha de publicación

2023.02

Título

High-dimensional Statistics Non-precient myopia (US) Martin J. Wendite Statistics Mechanical Industry Press

Pie

16 open

Número de libro

9787111716761

Precios de los libros

149.00

Marca

42960263

Editorial

Machinery Industry Press

Autor

(american) Martin J. Wendite

Fecha de publicación

2023.02

Título

High-dimensional Statistics Non-precient myopia (US) Martin J. Wendite Statistics Mechanical Industry Press

Pie

16 open

Número de libro

9787111716761

Precios de los libros

149.00

Marca

42960263

Editorial

Machinery Industry Press

Autor

(american) Martin J. Wendite

Fecha de publicación

2023.02

Título

High-dimensional Statistics Non-precient myopia (US) Martin J. Wendite Statistics Mechanical Industry Press

Pie

16 open

Número de libro

9787111716761

Precios de los libros

149.00

Detalles del producto

El texto en las imágenes se puede traducir

autor:(EE. UU.) Escrito por Martin J. Wainwright Wang Cheng, traducido por Liu Weidong

Precios:149

Editor:Prensa de la industria mecánica

Fecha de publicación:1 de febrero de 2023

Páginas:480

Vinculante:libro de bolsillo

ISBN:9787111716761

●Elogio del libro

Prefacio del traductor

Expresiones de gratitud

Capítulo 1 Introducción 1

1.1 Teoría clásica y teoría de alta dimensión 1

1.2 ¿Qué problemas surgirán en altas dimensiones?

1.2.1 Análisis Discriminante Lineal 2

1.2.2 Estimación de Covarianza 4

1.2.3 Regresión no paramétrica 6

1.3 ¿Qué puede ayudarnos en dimensiones superiores?

1.3.1 Esparsidad de Vector 8

1.3.2 Estructura en la Matriz de Covarianza 10

1.3.3 Estructura de la forma de regresión 11

1.4 ¿Cuál es la visión no asintótica? 12

1.5 Resumen del libro 13

1.5.1 Contenidos de cada capítulo 13

1.5.2 Requisitos de Lectura de Fondo 14

1.5.3 Sugerencias de enseñanza y diagrama de flujo 15

1.6 Referencias y Antecedentes 16

Capítulo 2 Cotas Básicas de Probabilidad de Cola y Desigualdades de Concentración 18

2.1 Límite Clásico 18

2.1.1 De la Desigualdad de Markov a la Cota de Chernoff 18

2.1.2 Variables aleatorias subgaussianas y la cota de Hoeffding 19

2.1.3 Variables Aleatorias Exponenciales y la Cota de Bernstein 22

2.1.4 Algunos Resultados Unilaterales 26

2.2 Métodos basados en martingala 28

2.2.1 Antecedentes 28

2.2.2 Límites de Concentración de Secuencias de Diferencias de Martingala 30

2.3 Función de Lipschitz de Variables Aleatorias Gaussianas 35

2.4 Apéndice A: Equivalencia de Variables Aleatorias Subgaussianas 39

2.5 Apéndice B: Equivalencia de Variables Aleatorias Subexponenciales 42

2.6 Referencias y Antecedentes 43

2.7 Ejercicio 44

Capítulo 3 Medición de la Concentración 51

3.1 Concentración basada en la técnica de entropía 51

3.1.1 Entropía y propiedades relacionadas 51

3.1.2 Método de Herbst y sus extensiones 52

3.1.3 Funciones Convexas Separables y Métodos de Entropía 54

3.1.4 Tensorización y Funciones Convexas Separables 56

3.2 Vista geométrica de la concentración 58

3.2.1 Función de Concentración 59

3.2.2 Relación con las funciones de Lipschitz 60

3.2.3 De la Geometría a la Concentración 63

3.3 Distancia de Wasserstein y desigualdad de información 66

3.3.1 Distancia de Wasserstein 66

3.3.2 Costo de Transmisión y Desigualdad de Concentración 67

3.3.3 Tensorización del Costo de Transmisión 70

3.3.4 Desigualdad del costo de transmisión para cadenas de Markov 71

3.3.5 El acoplamiento asimétrico cuesta 72

3.4 Cotas de Probabilidad de Cola de Procesos Empíricos 75

3.4.1 Una desigualdad funcional de Hoeffding 75

3.4.2 Una desigualdad funcional de Bernstein 77

3.5 Referencias y Antecedentes 79

3.6 Ejercicio 80

Capítulo 4 Ley Uniforme de los Grandes Números 85

4.1 Motivación 85

4.1.1 Convergencia Uniforme de Funciones de Distribución Acumulativa 85

4.1.2 Leyes de Consistencia para Clases Más Generales de Funciones 87

4.2 Leyes de Consistencia Basadas en la Complejidad de Rademacher 90

4.3 Cotas Superiores de la Complejidad de Rademacher 94

4.3.1 Clases de Funciones para la Identificación de Polinomios 94

4.3.2 Dimensión de Vapnik-Chervonenkis 96

4.3.3 Control de la Dimensión VC 99

4.4 Referencias y Antecedentes 100

4.5 Ejercicio 101

Capítulo 5 Medición de la Entropía y sus Usos 104

5.1 Cubriendo y rellenando 104

5.2 Complejidad Gaussiana y Complejidad de Rademacher 113

5.3 Entropía Métrica y Procesos Sub-Gaussianos 115

5.3.1 Supremo de la discretización de un paso 116

5.3.2 Ejemplos de Límites de Discretización 117

5.3.3 Método de Cadena e Integración de Entropía de Dudley 119

5.4 Algunas desigualdades de comparación gaussianas 123

5.4.1 Resultados Generales de Comparación de Desigualdades 123

5.4.2 Desigualdades de Slepian y Sudakov–Fernique 125

5.4.3 Desigualdad de contracción gaussiana 126

5.5Cota inferior de Sudakov 127

5.6 Métodos de Cadena y Proceso de Orlicz 128

5.7 Referencias y Antecedentes 131

5.8 Ejercicio 132

Capítulo 6 Matrices Aleatorias y Estimación de Covarianza 136

6.1 Conocimientos Preliminares 136

6.1.1 Notación y resultados básicos 136

6.1.2 Problema de Estimación de la Matriz de Covarianza 137

6.2 Matriz de Wishart y sus propiedades 138

6.3 Matriz de Covarianza de una Población Subgaussiana 141

6.4 Cotas de Matrices Generales 144

6.4.1 Conocimientos básicos de análisis matricial 144

6.4.2 Condiciones de Cola de la Matriz 145

6.4.3 Método de Chernoff Matricial y Descomposición Independiente 147

6.4.4 Límites de Probabilidad de Cola Superior para Matrices Aleatorias 149

6.4.5 Resultados de la matriz de covarianza 153

6.5 Cotas en matrices de covarianza estructuradas 154

6.5.1 Esparcidad y Truncamiento Desconocidos 155

6.5.2 Asintóticamente Ralo 157

6.6 Apéndice: Demostración del Teorema 6.1 159

6.7 Referencias y Antecedentes 161

6.8 Ejercicio 162

Capítulo 7 Modelos Lineales Dispersos en Altas Dimensiones 167

7.1 Problemas y Aplicaciones 167

7.1.1 Diferentes Modelos Esparsos 167

7.1.2 Aplicaciones de Modelos Lineales Dispersos 168

7.2 Restauración en la Situación Libre de Ruido 171

7.2.1 Relajación L1 172

7.2.2 Restauración precisa y espacio nulo 172

7.2.3 Condiciones suficientes para el espacio nulo 174

7.3 Estimación en presencia de ruido 178

7.3.1 Condiciones de valor propio restringido 178

7.3.2 Límites de error L2 para modelos estrictamente dispersos 180

7.3.3 Espacio Nulo Restringido y Valores Propios de la Matriz de Diseño Aleatorio 203

7.4 Límites en los errores de predicción 186

7.5 Selección de Variables o Subconjuntos 188

7.5.1 Consistencia de la selección de variables para Lasso 188

7.5.2 Demostración del Teorema 7.21 191

7.6 Apéndice: Demostración del Teorema 7.16 193

7.7 Referencias y Antecedentes 195

7.8 Ejercicio 197

Capítulo 8 Análisis de Componentes Principales en Altas Dimensiones 204

8.1 Componentes Principales y Reducción de Dimensionalidad 204

8.1.1 Interpretación y Aplicación de PCA 205

8.1.2 Valores propios y perturbaciones del espacio propio 208

8.2 Cotas sobre vectores propios generalizados 209

8.2.1 Un Resultado Determinista General 209

8.2.2 Resultados para una Población de Espigas 211

…

Prefacio del traductor

Expresiones de gratitud

Capítulo 1 Introducción 1

1.1 Teoría clásica y teoría de alta dimensión 1

1.2 ¿Qué problemas surgirán en altas dimensiones?

1.2.1 Análisis Discriminante Lineal 2

1.2.2 Estimación de Covarianza 4

1.2.3 Regresión no paramétrica 6

1.3 ¿Qué puede ayudarnos en dimensiones superiores?

1.3.1 Esparsidad de Vector 8

1.3.2 Estructura en la Matriz de Covarianza 10

1.3.3 Estructura de la forma de regresión 11

1.4 ¿Cuál es la visión no asintótica? 12

1.5 Resumen del libro 13

1.5.1 Contenidos de cada capítulo 13

1.5.2 Requisitos de Lectura de Fondo 14

1.5.3 Sugerencias de enseñanza y diagrama de flujo 15

1.6 Referencias y Antecedentes 16

Capítulo 2 Cotas Básicas de Probabilidad de Cola y Desigualdades de Concentración 18

2.1 Límite Clásico 18

2.1.1 De la Desigualdad de Markov a la Cota de Chernoff 18

2.1.2 Variables aleatorias subgaussianas y la cota de Hoeffding 19

2.1.3 Variables Aleatorias Exponenciales y la Cota de Bernstein 22

2.1.4 Algunos Resultados Unilaterales 26

2.2 Métodos basados en martingala 28

2.2.1 Antecedentes 28

2.2.2 Límites de Concentración de Secuencias de Diferencias de Martingala 30

2.3 Función de Lipschitz de Variables Aleatorias Gaussianas 35

2.4 Apéndice A: Equivalencia de Variables Aleatorias Subgaussianas 39

2.5 Apéndice B: Equivalencia de Variables Aleatorias Subexponenciales 42

2.6 Referencias y Antecedentes 43

2.7 Ejercicio 44

Capítulo 3 Medición de la Concentración 51

3.1 Concentración basada en la técnica de entropía 51

3.1.1 Entropía y propiedades relacionadas 51

3.1.2 Método de Herbst y sus extensiones 52

3.1.3 Funciones Convexas Separables y Métodos de Entropía 54

3.1.4 Tensorización y Funciones Convexas Separables 56

3.2 Vista geométrica de la concentración 58

3.2.1 Función de Concentración 59

3.2.2 Relación con las funciones de Lipschitz 60

3.2.3 De la Geometría a la Concentración 63

3.3 Distancia de Wasserstein y desigualdad de información 66

3.3.1 Distancia de Wasserstein 66

3.3.2 Costo de Transmisión y Desigualdad de Concentración 67

3.3.3 Tensorización del Costo de Transmisión 70

3.3.4 Desigualdad del costo de transmisión para cadenas de Markov 71

3.3.5 El acoplamiento asimétrico cuesta 72

3.4 Cotas de Probabilidad de Cola de Procesos Empíricos 75

3.4.1 Una desigualdad funcional de Hoeffding 75

3.4.2 Una desigualdad funcional de Bernstein 77

3.5 Referencias y Antecedentes 79

3.6 Ejercicio 80

Capítulo 4 Ley Uniforme de los Grandes Números 85

4.1 Motivación 85

4.1.1 Convergencia Uniforme de Funciones de Distribución Acumulativa 85

4.1.2 Leyes de Consistencia para Clases Más Generales de Funciones 87

4.2 Leyes de Consistencia Basadas en la Complejidad de Rademacher 90

4.3 Cotas Superiores de la Complejidad de Rademacher 94

4.3.1 Clases de Funciones para la Identificación de Polinomios 94

4.3.2 Dimensión de Vapnik-Chervonenkis 96

4.3.3 Control de la Dimensión VC 99

4.4 Referencias y Antecedentes 100

4.5 Ejercicio 101

Capítulo 5 Medición de la Entropía y sus Usos 104

5.1 Cubriendo y rellenando 104

5.2 Complejidad Gaussiana y Complejidad de Rademacher 113

5.3 Entropía Métrica y Procesos Sub-Gaussianos 115

5.3.1 Supremo de la discretización de un paso 116

5.3.2 Ejemplos de Límites de Discretización 117

5.3.3 Método de Cadena e Integración de Entropía de Dudley 119

5.4 Algunas desigualdades de comparación gaussianas 123

5.4.1 Resultados Generales de Comparación de Desigualdades 123

5.4.2 Desigualdades de Slepian y Sudakov–Fernique 125

5.4.3 Desigualdad de contracción gaussiana 126

5.5Cota inferior de Sudakov 127

5.6 Métodos de Cadena y Proceso de Orlicz 128

5.7 Referencias y Antecedentes 131

5.8 Ejercicio 132

Capítulo 6 Matrices Aleatorias y Estimación de Covarianza 136

6.1 Conocimientos Preliminares 136

6.1.1 Notación y resultados básicos 136

6.1.2 Problema de Estimación de la Matriz de Covarianza 137

6.2 Matriz de Wishart y sus propiedades 138

6.3 Matriz de Covarianza de una Población Subgaussiana 141

6.4 Cotas de Matrices Generales 144

6.4.1 Conocimientos básicos de análisis matricial 144

6.4.2 Condiciones de Cola de la Matriz 145

6.4.3 Método de Chernoff Matricial y Descomposición Independiente 147

6.4.4 Límites de Probabilidad de Cola Superior para Matrices Aleatorias 149

6.4.5 Resultados de la matriz de covarianza 153

6.5 Cotas en matrices de covarianza estructuradas 154

6.5.1 Esparcidad y Truncamiento Desconocidos 155

6.5.2 Asintóticamente Ralo 157

6.6 Apéndice: Demostración del Teorema 6.1 159

6.7 Referencias y Antecedentes 161

6.8 Ejercicio 162

Capítulo 7 Modelos Lineales Dispersos en Altas Dimensiones 167

7.1 Problemas y Aplicaciones 167

7.1.1 Diferentes Modelos Esparsos 167

7.1.2 Aplicaciones de Modelos Lineales Dispersos 168

7.2 Restauración en la Situación Libre de Ruido 171

7.2.1 Relajación L1 172

7.2.2 Restauración precisa y espacio nulo 172

7.2.3 Condiciones suficientes para el espacio nulo 174

7.3 Estimación en presencia de ruido 178

7.3.1 Condiciones de valor propio restringido 178

7.3.2 Límites de error L2 para modelos estrictamente dispersos 180

7.3.3 Espacio Nulo Restringido y Valores Propios de la Matriz de Diseño Aleatorio 203

7.4 Límites en los errores de predicción 186

7.5 Selección de Variables o Subconjuntos 188

7.5.1 Consistencia de la selección de variables para Lasso 188

7.5.2 Demostración del Teorema 7.21 191

7.6 Apéndice: Demostración del Teorema 7.16 193

7.7 Referencias y Antecedentes 195

7.8 Ejercicio 197

Capítulo 8 Análisis de Componentes Principales en Altas Dimensiones 204

8.1 Componentes Principales y Reducción de Dimensionalidad 204

8.1.1 Interpretación y Aplicación de PCA 205

8.1.2 Valores propios y perturbaciones del espacio propio 208

8.2 Cotas sobre vectores propios generalizados 209

8.2.1 Un Resultado Determinista General 209

8.2.2 Resultados para una Población de Espigas 211

…

En los últimos años, ha habido una explosión en la cantidad y variedad de datos recopilados en todas las disciplinas científicas y entornos industriales. Estos grandes conjuntos de datos plantean muchos desafíos a los investigadores en estadística y aprendizaje automático. Este libro proporciona una introducción exhaustiva a la estadística de alta dimensión, centrándose en la metodología y teoría centrales, incluyendo cotas de cola, desigualdades de concentración, leyes consistentes y procesos empíricos, y matrices aleatorias. Se exploran en profundidad clases específicas de modelos, incluyendo modelos lineales dispersos, modelos con restricciones de rango, modelos gráficos y varios tipos de modelos no paramétricos. Con cientos de ejemplos resueltos y ejercicios, el libro es adecuado para usar en cursos de estadística así como para el autoestudio por parte de estudiantes de posgrado e investigadores en estadística, aprendizaje automático y campos relacionados.

Total

Entrega

IVA

Otro